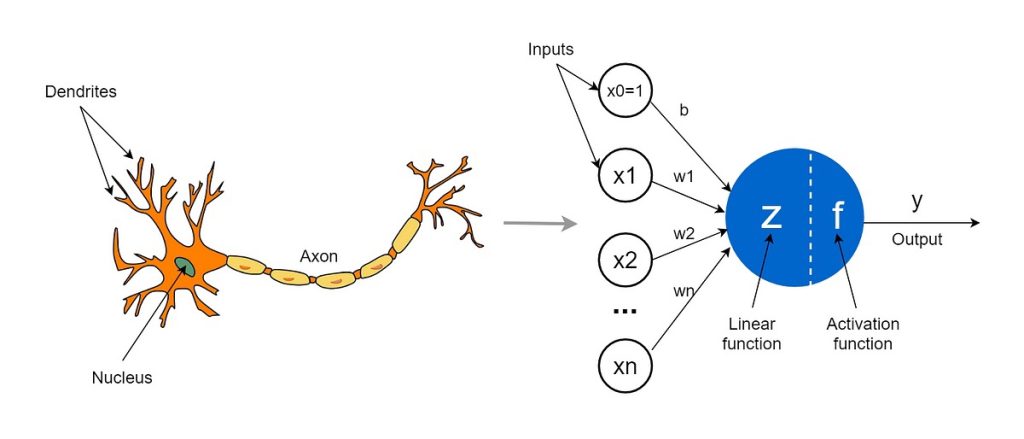

LM이 학습을 통해 쌓은 언어 능력은 실제로 다양한 분야에서 폭넓게 활용되며, 각 분야에 상당한 변화를 일으키고 있습니다. 이러한 언어 모델은 텍스트 이해와 생성 능력을 바탕으로 대화형 AI와 자동 번역부터 시작해, 전문적인 영역인 의료, 법률, 금융 등에서의 지원 기능을 수행하며 실생활의 다양한 부분에서 중요한 역할을 맡고 있습니다.

. 언어 이해와 생성 – 대화형 AI와 자동 번역

LLM이 가장 활발하게 활용되는 대표적인 분야는 대화형 AI와 자동 번역입니다. ChatGPT와 같은 대화형 AI는 사람과 자연스럽게 소통하며 정보 제공, 문제 해결, 글쓰기 보조 등 다양한 역할을 수행합니다. 또한, 번역 기술에도 뛰어나며, 여러 언어의 문맥을 이해하여 정확한 번역을 제공합니다. 이는 글로벌 커뮤니케이션을 가능하게 하는 중요한 도구로 자리 잡았습니다.

2. 전문 분야에서의 지원 – 의료, 법률, 금융

LLM은 의료, 법률, 금융 등 전문 지식이 필요한 영역에서도 중요한 보조 역할을 수행하고 있습니다. 의료 분야에서는 환자의 건강 기록을 분석하거나 의학 논문을 요약하여 의사들이 빠르게 참조할 수 있도록 돕고 있으며, 법률 분야에서는 복잡한 법률 문서를 요약하고 주요 정보를 정리하는 데 도움을 줍니다. 금융에서는 방대한 양의 데이터를 분석하여 시장 트렌드를 예측하고, 리스크를 관리하는 데 유용한 인사이트를 제공합니다.

환자 기록 요약 AI, 법률 문서 요약 도구, 금융 데이터 분석 및 리스크 관리 시스템 등에 적용되고 있습니다.

3. 창의적 콘텐츠 생성 – 글쓰기, 음악, 예술

LLM은 텍스트 기반 창의적 콘텐츠 생성에도 큰 역할을 하고 있습니다. 뉴스 기사나 블로그 글 초안 작성부터 시작해, 소설 줄거리 작성, 광고 카피 제작 등에서도 사용되고 있습니다. 예술 분야에서는 시나리오 초안 작성, 음악 가사 창작, 시 창작 등 다양한 창의적 활동에서 유용하게 활용됩니다.

언론사에서 사용하는 기사 초안 생성 도구, 광고 및 마케팅 부서의 카피 작성 지원, 음악 및 예술 분야의 아이디어 도출 등에 활용되고 있습니다.

4. 맞춤형 학습 및 교육 지원

대규모 언어 모델(LLM)은 교육 분야에서 다양한 방식으로 활용되고 있습니다. 학생들의 질문에 답변하고, 복잡한 개념을 쉽게 설명하며, 맞춤형 학습 계획을 수립하는 데 도움을 주는 등 학습 보조 역할을 수행합니다. 특히 언어 학습, 수학 문제 풀이, 과학 개념 설명 등에서 두각을 나타내고 있습니다.

언어 학습 애플리케이션: LLM을 활용한 언어 학습 애플리케이션은 사용자와의 대화를 통해 자연스러운 언어 습득을 지원합니다. 예를 들어, Duolingo는 AI 기반의 맞춤형 학습 경험을 제공하여 사용자들이 효과적으로 새로운 언어를 배울 수 있도록 돕습니다.

온라인 튜터링 프로그램: LLM을 통합한 온라인 튜터링 플랫폼은 학생들의 질문에 실시간으로 답변하고, 복잡한 개념을 이해하기 쉽게 설명합니다. 예를 들어, Khan Academy는 AI를 활용하여 학생들에게 개인 맞춤형 학습 경험을 제공합니다.

맞춤형 학습 지원 시스템: LLM 기반의 학습 지원 시스템은 학생들의 학습 패턴을 분석하여 개인별 맞춤형 학습 계획을 수립합니다. 이를 통해 학습 효율성을 높이고, 학생들의 이해도를 향상시키는 데 기여합니다.

이러한 사례들은 LLM이 교육 분야에서 학습자 중심의 맞춤형 교육을 실현하는 데 중요한 역할을 하고 있음을 보여줍니다.

5. 연구와 데이터 분석 – 방대한 정보의 효율적 처리

마지막으로, LLM은 방대한 데이터를 요약하고 분석하는 데도 활용되고 있습니다. 과학 논문 요약, 정보 검색, 연구 트렌드 분석 등 다양한 분야에서 정보의 핵심을 빠르게 파악하고 연구자들이 중요한 데이터에 접근할 수 있도록 돕습니다.

연구 논문 요약, 문헌 검토 및 연구 트렌드 분석 도구 등에서 효과적으로 활용되고 있습니다.